AI盗脸盯上美国学生:靠黄图造谣,有人月入20万,受害者求偿无门(组图)

“你是不是得罪了什么人?”

你正在被数十万的网友意淫。

你的脸被AI合成在另一个裸露的身体上,做着奇怪的姿势和动作。

一大堆人拿着女性的照片“求换脸”,“他们说,这是他们的同事、同学或者青梅竹马。”

甚至有人靠着这些假“黄图”赚的盆满钵满。图片收费在30-50元不等,视频则根据时长收费在几十到几百元不等。此外,他还提出可以加盟,学费5000元,提供电脑程序和远程演示过程,学会了,就可以自己用技术换脸,甚至用来盈利。

他的收入令人咋舌,“我这个月快20W了。”

最近,新泽西州威斯特菲德高中(Westfield High School)女学生发现网络流传自己的色情图片,事后证实是通过人工智能(AI)生成的假图片,家长虽已报警处理,但受害女学生目前仍心有余悸,当地议员也打算立法禁止相关行为。

“我很怕,裸照在网上搜得到,感觉天都塌了,我走路都低着头,不敢和别人对视,已经连续半个月没睡好觉了,常常被噩梦惊醒!”

在美国校园中,利用女同学的照片生成色情图像或影片早已不是新鲜事,由此产生的恶劣事件,也屡次登上新闻媒体版面。然而,这类“AI一键脱衣”的网站和软件仍然大肆流行,对受害者造成的伤害也在持续扩大。

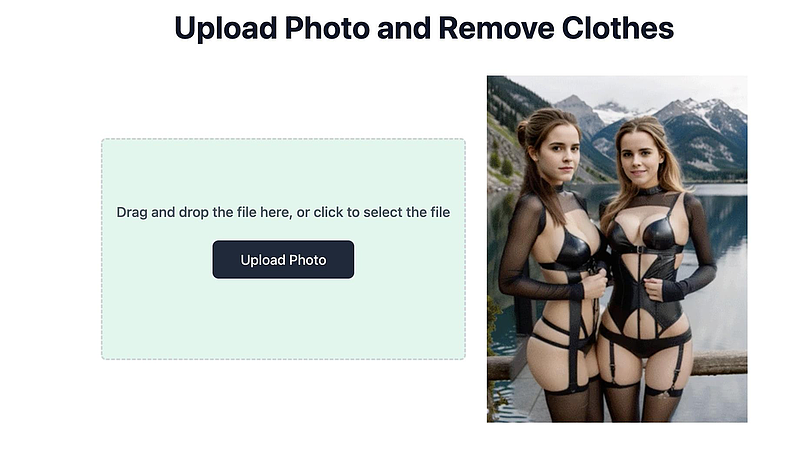

在Google搜索引擎上,只要输入“AI nude”、“deepnude”等关键词,便可轻松找到免费生成色情内容的网站。用户只需上传目标人物照片,就可以轻松脱掉他们身上的衣服,或生成想要的影像剧情。

一位不愿具名的南加高中生透露,类似的游戏,在校园内早已是公开的秘密,“没什么新鲜的,只不过大部分同学都不会跟别人分享。”

这类技术统称为Deepfake,AI工具基于数百万张图像的数据库,分析照片或影片中人体的裸体效果并进行预测,从而流畅地将目标人物的五官叠加至色情照片或影片中。在社交媒体讨论平台Reddit、Quora上,与利用Deepfake技术制作裸体内容的资源和技术交流群组五花八门,甚至还有专门针对亚裔女孩的制作平台推荐。

根据信息咨询公司Sensity数据,在这些Deepfake技术网站中,超过90%的图像都与色情内容有关。

多项研究表明,这类影片对受害者的心理健康产生破坏性影响,包括忧郁症、创伤后压力症候群和自杀念头。

但令人沮丧的是,当盗脸事件发生,普通人往往维权困难。在大部分地区,这类影片的受害者基本没有求偿办法。美国目前尚未颁布针对此类色情内容的联邦法律,只有极少数州通过对未经同意的色情Deepfake技术(nonconsensual pornographic deepfakes,简称NPD)或人工智能生成的色情媒体的法律限制。

加州州长纽森曾于2019年签署两项针对Deepfake技术的法案,其中的AB602法案规定,允许加州居民在自己的图像被用于露骨色情内容时提告,受害者可“寻求禁制令并索要合理的律师费和赔偿”。但该法只提供民事诉讼的权利,并未将共享NPD内容定为犯罪。

更重要的是,由于互联网的广度和覆盖范围,这些法律在实施时异常困难。互联网不以州为界,这些影像创作者可能不在受害对象的所在州,甚至不处于同一国家,一个地方的某些非法行为,在另一地方可能合法。而且在多数情况下,受害者甚至不知道应该告谁。

此外,法律学者警告,AI伪造的图像,可能不受个人肖像的版权保护,因为它们取自包含数百万张图像的数据集。NPD虽与法律上的非自愿影像性暴力(Image-based sexual abuse)有相似之处,但NPD案件却常处于灰色地带,让受害者在寻求法律援助时碰壁。例如,法律定义的影像性暴力中的身体隐私部位,须是受害者本人,但NPD中的身体,其实不是受害者本人的身体,而是数百万图像的集合。

除司法和执法方面的挑战,NPD相关的立法也时常受到利益相关者阻挠。例如纽约州的一项法案,禁止在未经主体同意的情况下,创作基于Deepfake技术的色情作品。即使主体人物已经过世,也是如此。该法案遭到美国电影协会反对,他们担心这样的法律,可能会阻碍传记片制作,这类影片常包含已故名人的“数字”拷贝品。

+61

+61 +86

+86 +886

+886 +852

+852 +853

+853 +64

+64